前言

資訊及通訊技術 (ICT) 透過軟硬體、演算法、系統架構、電路、元件、材料和半導體製程技術等方面的持續創新,使計算無處不在。然而,ICT 在保持其未來十年的增長率方面,面臨前所未有的技術挑戰。

這些挑戰主要來自技術發展已趨近半導體技術的各種基本限制,這些限制降低了在資訊的處理、傳輸、儲存、感知和驅動等方面的能源效率上之必要的世代改善。

長期可持續的 ICT 成長仰賴於半導體技術能力的突破,使整體解決方案能夠提高資訊處理效率。需要在軟體、系統、架構、電路、元件結構及相關半導體製程、材料等領域取得顛覆性的突破,而這些都需要及時、協調良好的多學科研究工作的配合。

美國 SIA 和 SRC 提出半導體十年計劃

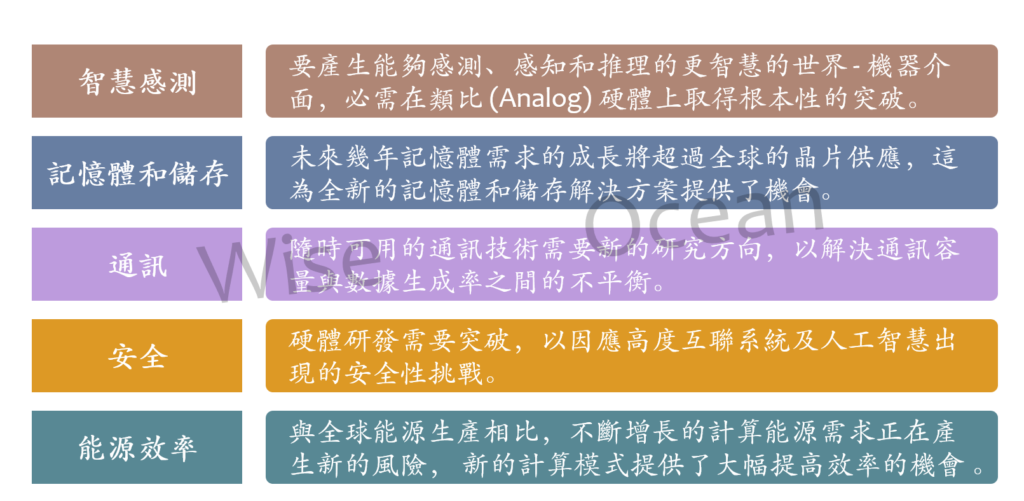

2020 年底美國半導體產業協會 (SIA) 和半導體研究公司 (SRC) 聯合發表一份 “半導體十年計劃”報告書,此計劃是由學術界、政府和工業界之領導者所共同制定。計畫列出五個未來十年半導體發展的主要方向,以因應及塑造美國半導體晶片技術和資訊及通訊技術 (ICT) 的未來發展。

報告呼籲美國政府在未來十年內每年進行 34 億美元的聯邦投資,用以資助智慧感測、記憶體和儲存、通訊、安全、以及能源效率這五個領域的半導體技術研發,以確保美國半導體和資訊及通訊技術產業的可持續成長。

巨大轉變 (一) — 智慧感測

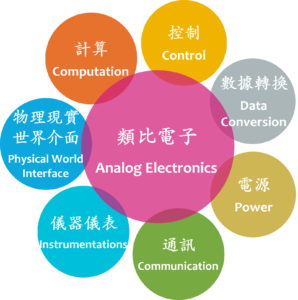

類比電子 (Analog Electronics) 的維度

類比電子 (Analog Electronics) 的維度

類比 (Analog) 電子元件處理現實世界中各種形式的連續可變信號,這與數位 (Digital) 電子元件不同,數位電子元件通常具有標準形狀的信號僅採用兩個電位,1 或 0。

人類居住的物理現實世界本質上是類比的,人類可以感知的所有輸入都是類比的,為實現類比的物理世界和數位的計算機世界間的互動,我們對先進類比電子產品的需求日益增加。

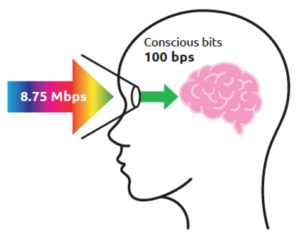

具備超壓縮能力的人類大腦感知能力

人類大腦的感測、感知和推理能力是基於超壓縮的感知能力。

下圖顯示,人腦感知能力能將外來之每秒 8.75 百萬位元 (Mbps) 的感測訊息壓縮到每秒 100 位元 (bps),這代表約 100,000 倍的數據壓縮能力,並且是低功率運行。

我們需要開發仿生 (Bio-Inspired) 的世界 – 機器介面解決方案,能夠基於超壓縮及低功耗來進行感測、感知和推理。

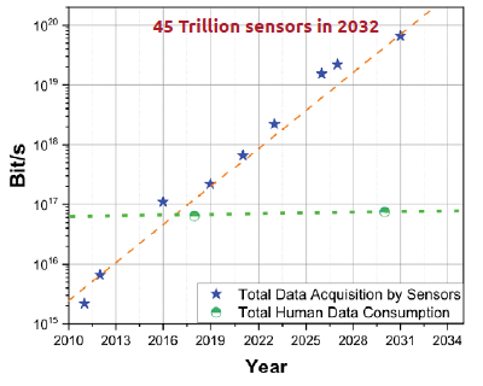

人類的總集體感知處理量遠遠不足

預測到 2034 年,現實物理世界所產生的總類比資訊約為 10^34 bit/秒。而目前人類的總集體感知處理量只有約 10^17 bit/秒,這是一萬兆倍的差異。

到 2032 年全世界將有約 45 兆個感測器,每年產生超過 100 萬 Zettabytes (10^27 Bytes) 的數據,這大約是 10^20 bit/秒,已超過人類總集體感知處理量。

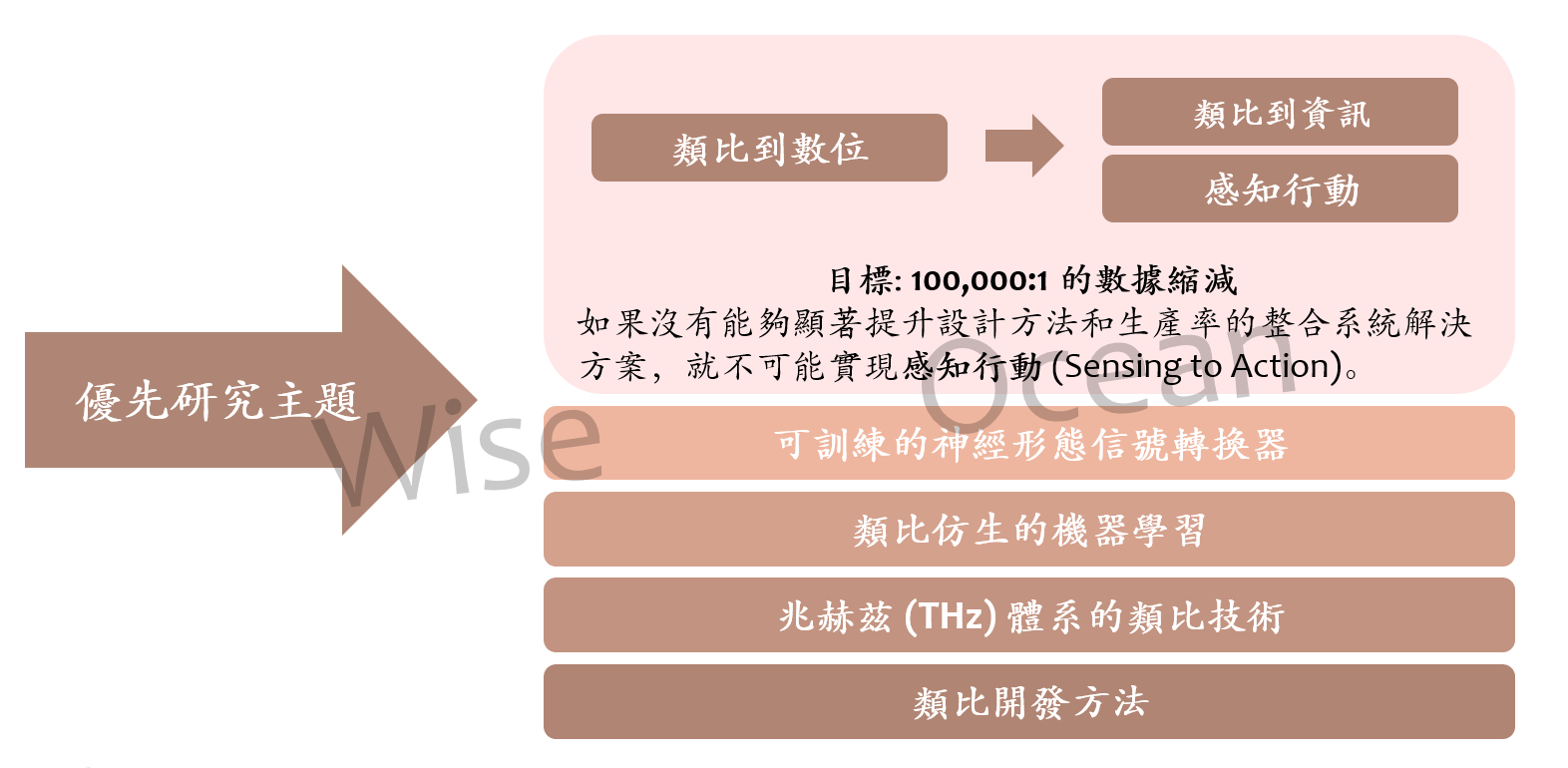

因此未來幾年必須在類比電子方面取得突破性進展。諸如感知行動 (Sensing to Action)、類比“人工智慧” (AI) 平台、大腦啟發/神經形態和分層計算等新的感知方法將是必要的。

採取行動

- 對於許多即時應用程式而言,感官數據的價值是非常短暫的,有時只有幾毫秒 (ms),又必須在該時間範圍內使用,基於延遲和安全考慮,必須在本地 (Local) 處理及使用數據。

- 因此,在資訊處理技術上必須尋求一些突破性的進展,例如 :

- 開發能夠從原始感測器數據中了解環境的分層感知演算法。

- 開發新的計算模型,例如類比“近似計算 (Approximate Computing)”。

- 開發新的類比技術,在輸入/輸出端 (I / O) 收集、處理和傳遞類比數據的能力對於未來的物聯網 (IoT) 和大數據世界至關重要,未來的感測和通訊需求都需要將類比技術提升到兆赫茲 (Tera Hertz,THz) 體系。(註 : 兆赫茲 (Tera Hertz,THz) 是頻率介於 300GHz ~ 10THz 的電磁波,也有人稱為「太赫茲」,屬於「遠紅外線 (FIR: Far Infrared)」的一種,是未來 6G 所使用的技術之一)

目標: 100,000:1 的數據縮減,如果沒有能夠顯著提升設計方法和生產率的整合系統解決方案,就不可能實現感知行動 (Sensing to Action)。

建議:在未來十年,每年投資 6 億美元在類比電子的新軌道相關技術研發

巨大轉變 (二) — 記憶體和儲存

現有之記憶體和儲存技術即將面臨瓶頸

記憶體和儲存需求的增長將超過矽晶片的全球供應量,這為全新的記憶體和儲存技術解決方案提供了機會。

- 隨著元件、電路和架構的重大創新,以及伴隨人工智慧及其他應用所導致之數據量的指數型增長,再加上在十年之內,底層記憶體和儲存技術將達到製程技術縮放極限,資訊和通信技術 (ICT) 能源效率和性能的持續提升將停滯不前。

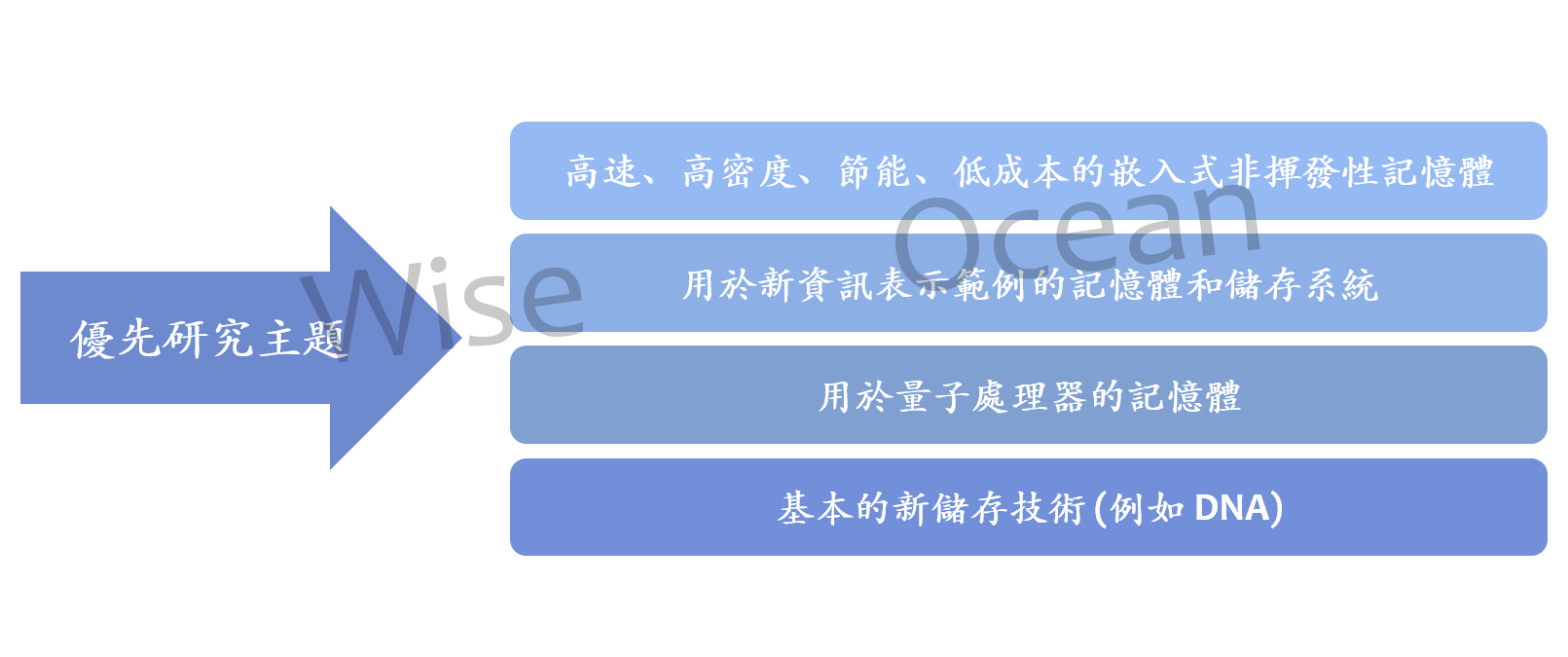

- 因此需要研發及採用全新的記憶體和儲存技術解決方案來因應未來的資訊和通信技術 (ICT) 發展需求將需要採用全新的記憶體和儲存技術解決方。從材料、元件到電路和系統級功能的協同創新 (很可能使用尚未探索的物理原理) 將是實現更高層級的位元密度、能源效率和性能的關鍵。

計算機之記憶體系統需重新研發

記憶體,例如 DRAM,是計算機的重要組成部分,如果不“重新研發” 計算機之記憶體系統,包括元件物理、記憶體層次結構和物理實現所需之半導體製程技術,就不可能在計算技術上取得進一步的發展。

例如,傳統之嵌入式非揮發性記憶體 (Embedded Nonvolatile Memory) 無法再縮放到 28 奈米 (nm) 製程技術以下,因此需要新的替代方案。

新的記憶體解決方案必須能夠支援多個新興應用,例如。人工智慧、大規模異構高性能和數據中心計算、以及滿足汽車市場惡劣環境需求的各種行動應用程式等等。

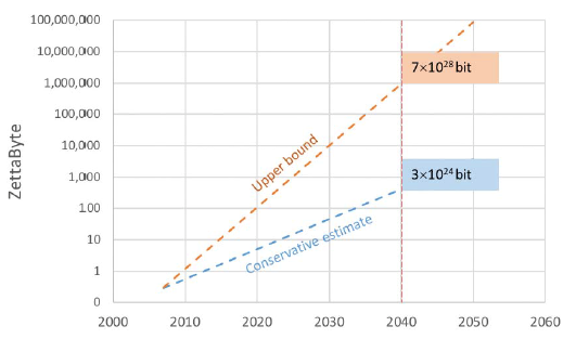

全球數據儲存需求呈現指數型增長

上圖顯示全球數據儲存需求的預測。目前資訊和通信技術數據的產生和使用量呈現指數型增長,到 2040 年全球儲存數據量的預估值在 10^24 到 10^28 位元之間。(中間值為 10^26 位元)

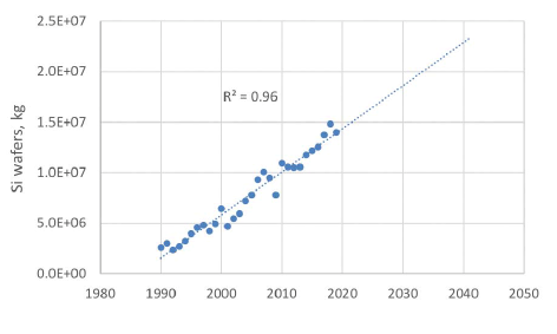

記憶體需求的增長將超過全球的矽供應量

達到製程縮放極致的 NAND 快閃記憶體 (NAND Flash Memory) 一個位元之重量預估可以小到 1 Picogram (10^-12 g),但要儲存 前述 10^26 位元所需的矽晶片總重量將達到約 10^10 kg,這將遠超過全球之矽晶片供應量。

全球的矽晶片供應量預估

大目標 (2a):針對記憶體層次結構 (Memory Hierarchy) 的每個層級,開發密度 > 10-100 倍且能源效率提升之新型記憶體和記憶體結構。

大目標 (2b):開發具有 > 100 倍儲存密度功能的儲存技術以及使用這些新技術的新儲存系統。

採取行動:

- 在記憶體和數據儲存方面取得突破性的進展的需求已迫在眉睫。

- 需要針對未來大容量節能儲存和數據/資訊儲存解決方案進行合作研發,包含 “從材料到元件,再到電路,再到體系結構,再到數據處理和解決方案”,以因應未來的廣泛應用。

建議:在未來十年,每年需要投資 7.5 億美元,用於記憶體和儲存的新發展

巨大轉變 (三) — 通訊

隨時隨處可用的通訊和連接性將面臨挑戰

隨時可用的通訊需要新的研究方向,以解決通訊容量與數據生成速率之間的不平衡問題。

- 現今世上已開發國家的特點是隨時(處)可用的通訊和連接性,這對生活各個方面都產生巨大的影響。雲端儲存和計算就是其中一項體現。

- 從任何地方獲取數據並將其發送到其他任何地方的能力,不僅已經改變了我們開展業務的方式,也改變了我們的個人習慣和生活方式,社群網路就是一個最佳例子。

- 然而,雲端的主要概念是基於網路隨時隨處的連接及通訊的假設,但這項假設並不能獲得持續保證。一項令人擔憂的趨勢是,隨著通訊需求以及數據產生量每天都在增長,既有通訊能力預估在 2022 年之後將無法傳輸全球的儲存數據。

- 為迎合隱私以及更快回應的需求, AI 系統的邊緣計算及儲存在地化趨勢正在發展, 這些許降低了一些原本往返雲端的數據傳輸量。但即使如此,資訊產生和儲存需求的爆炸式增長,仍需要雲端儲存和通訊基礎架構有巨大增長的支持才能維繫。

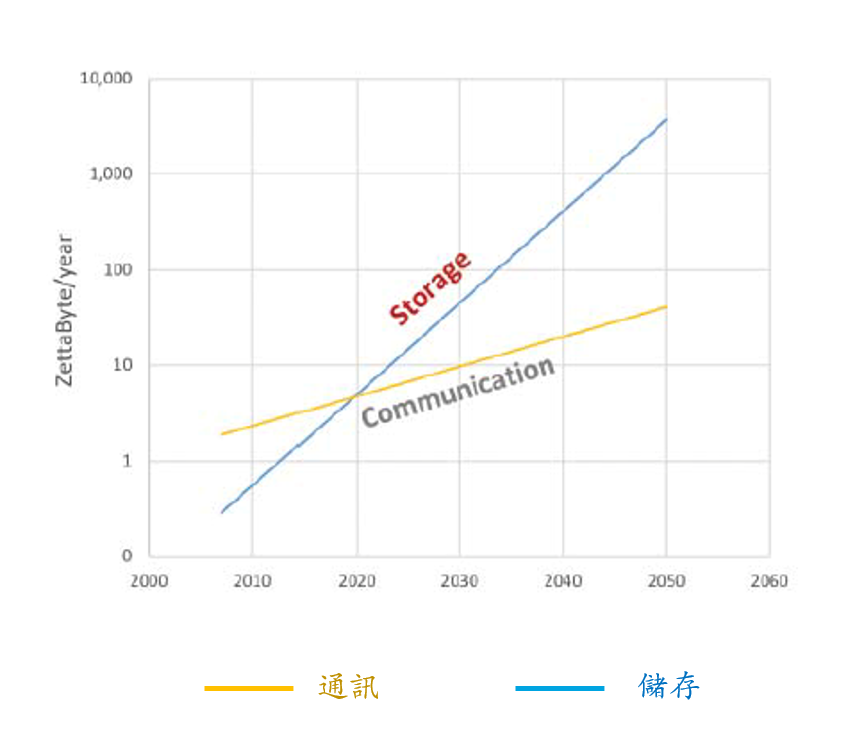

全球技術資訊儲存需求與通訊能力間的差距越來越大

- 如上圖所示,全球技術資訊儲存需求與通訊能力間的差距越來越大。

- 二條線型交叉預計 2022 年左右發生,數據傳輸將開始受到限制,這將對資訊及通訊技術 (ICT) 產生巨大影響。

- 依現有通訊能力發展,2040 年時每年所需傳輸的數據將需 20 年才能傳輸完畢。

大目標 (3a):先進的通訊技術可以 1Tbps @ <0.1nJ / bit 的峰值速率移動每年 100-1,000 zettabyte 的儲存數據。

大目標 (3b):開發能夠有效利用頻寬的智慧敏捷網路以最大化網路容量。

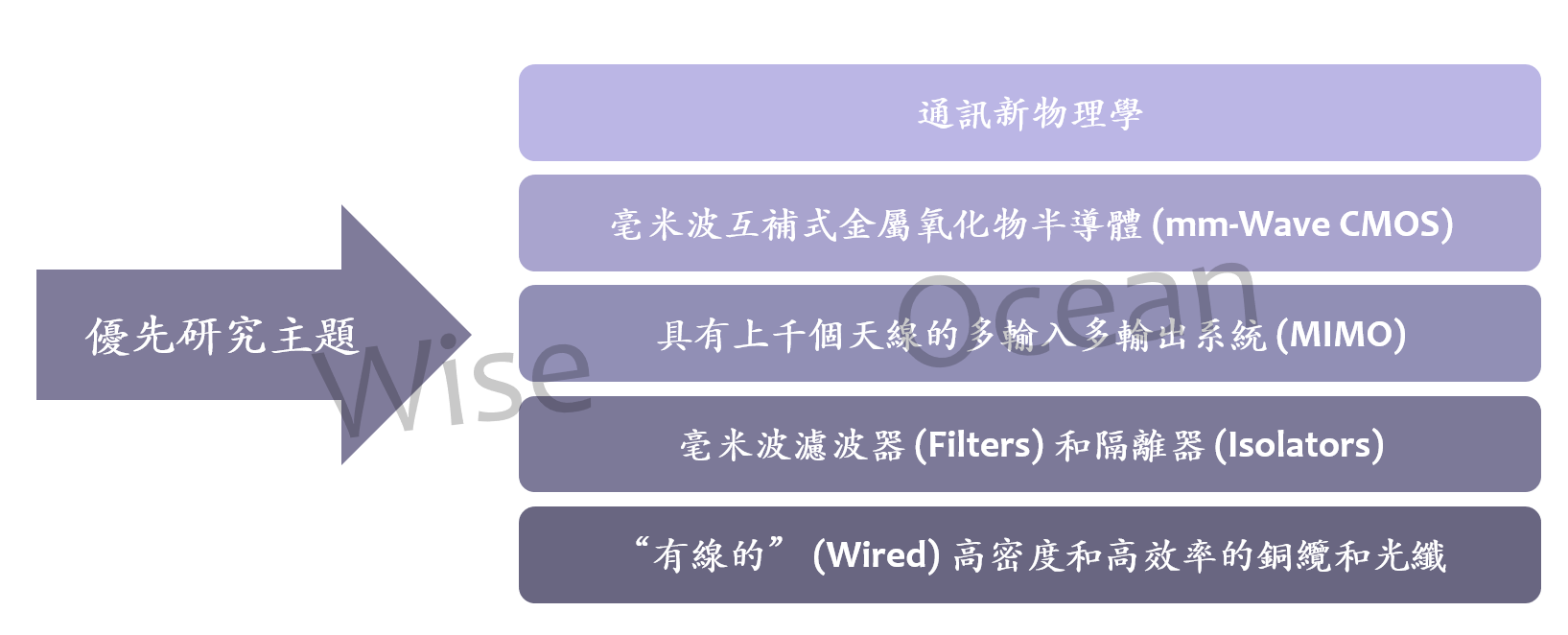

採取行動

- 通訊方面將需要取得根本性的進步。例如,雲端技術將會發生重大變化,重點轉向邊緣計算 (Edge Computing) 和本地數據儲存。

- 寬頻通訊將從智慧手機擴展到身臨其境的擴增實境 (Augmented Reality)、虛擬會議和智慧辦公室設置。新功能將透過新的應用實例和新的垂直市場來豐富用戶體驗。

- 因應未來的廣泛應用需要跨領域的合作研究,目的是建立革命性的模式來支持未來的大容量、高效率的通訊。

- 挑戰將包括無線通訊技術擴展到兆赫茲 (THz) 體系、無線和有線技術的相互作用、網路密集化的新方法、安全性的提升、毫米波的新架構、維持頻寬和功率要求、封裝和熱控制的元件技術。

建議:在未來十年,每年在通訊的新技術軌道上投資 7 億美元

巨大轉變 (四) — 安全

硬體研發需要突破,以因應高度互連系統及人工智慧所面臨的安全性挑戰。

安全和隱私領域正在面臨威脅

現今高度互連的系統和應用程式需要安全性和隱私性才能正常運行。

公司網路、社群網路和其他自主系統均建立在可靠和安全通訊的假設之上,但它們實際上卻面臨各種威脅和攻擊,範圍從敏感數據洩露到拒絕服務。隨著新案例、新威脅和新平台的出現,安全和隱私領域正在經歷快速變化。

隨著量子計算 (Quantum Computing) 的出現,新的威脅媒介將使當前的加密方法更容易遭受攻擊。因此,必須開發出抗量子攻擊的新加密標準。

此外,隱私已引起全球消費者和決策者越來越多的關注成為主要的政策問題。增強隱私的技術方法包括在收集或發佈時對數據進行混淆 (Obfuscating) 或加密。

裝置已經散佈到現實物理世界中,對這些裝置的信任也已成為安全問題。現在,系統的安全性和可靠性除了考慮傳統的隨機故障和現實物理世界系統性能降低外,還需考慮惡意攻擊。

網絡 – 物理系統的安全性需要考慮如何在遭受攻擊後仍然能繼續正常運行或優雅地失去作用。我們需要智慧演算法來篩選情境數據以評量信任度,隨著時間的推移實現安全的感測器融合。

這是一個難題,因為情境數據種類繁多,數量巨大 — 未來的系統實際上是具有無限通訊和發信號可能性的系統。例如,汽車可以彼此通訊,也可以與路邊基礎設施通訊。我們需要增強系統的智慧,以信任 (或不信任) 它們所感知到的一切。

複雜的硬體平台使系統的安全保護更加困難

由於性能和能源效率等驅動因素,當今的硬體平台變得非常複雜。現代的單晶片系統 (SoC) 設計結合一系列特殊用途加速器 (Accelerators) 和知識產權 (IP) 區塊。

這些系統的安全體系結構很複雜,而且因為這些系統是很小的分佈式系統,因此必須為每個組件建立具有不同信任假設 (Trust Assumptions) 的分佈式安全模型。此外,這些組件通常來自第三方,這意味著需要信任硬體供應鏈。

對性能的追求也導致了微架構 (Microarchitecture) 中的問題。例如,許多現有的硬體平台很容易受到推測執行的旁路攻擊,Spectre 和 Meltdown 就是其中二個著名的案例。

在上述問題及其他問題的驅使下,未來需要全新的硬體設計。

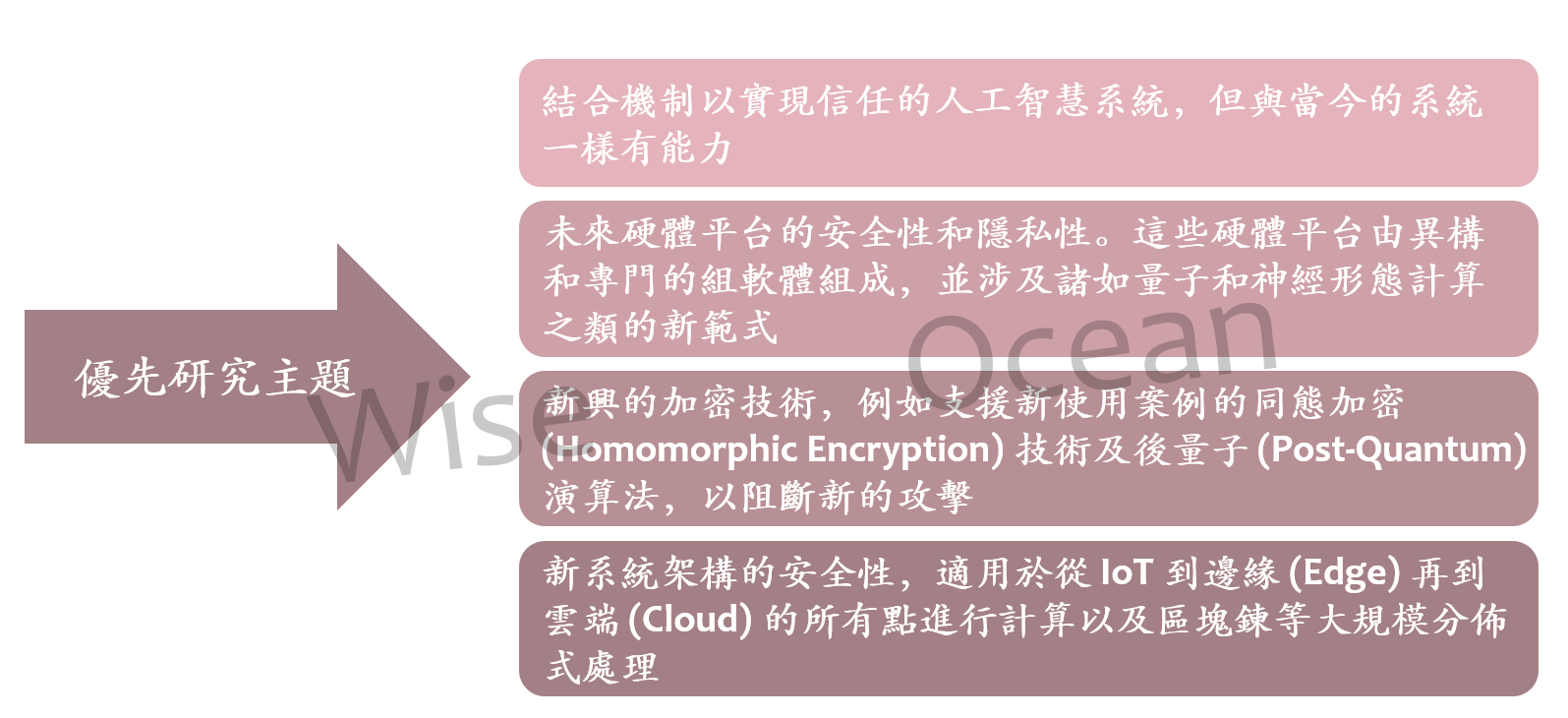

對人工智慧 (AI) 的信任尚有疑慮

今天為安全把關的工作主要是由 AI 來執行。例如,許多安全系統使用異常檢測來辨識攻擊或將特徵分析用於身份驗證。AI 的功能不斷增強,這些受信任系統的應用程式也在不斷增長。

但是,對於這些系統 AI 的信任尚有疑慮,例如自駕車的視覺辨識,影像上的微小擾動會干擾神經網路模型,從而得出錯誤的結論。停車標誌上的貼紙可以使模型將其誤判為速率限制標誌,即使二者形狀不同。

深度學習其他應用程式也存在類似的信任問題:語音辨識輸出可能受到音頻變化不明顯或惡意軟體的操縱。如果對二進制文件進行很小的更改,則可能無法檢測到。

深度學習模型的神經網路是個黑盒子,沒有解釋其決定方式。其他重要問題是演算法偏差和公平性。需要建立使深度學習系統更加可信、可解釋性和公平的方法。

雲端、邊緣計算及物聯網的安全及信任問題

在過去十年中,我們必須保護的系統變得異常複雜。雲端已經成為外包計算和儲存同時又讓自己保有控制力的標準。我們仍在努力因應雲端所帶來的安全挑戰 — 多租戶、供應商保證和隱私等。

如今雲端提供了受信任的執行環境以及專用的共享硬體和軟體。同時,由於我們意識到雲端缺乏在地計算基礎架構的性能和隱私保證,因此對邊緣計算 (Edge Computing) 的興趣正在增長,但邊緣的異構性質又帶來對邊緣服務供應商的信任問題。

物聯網 (IoT) 設備的安全性已困擾我們許多年,對於這些資源受限且通常為低成本的設備,必須使安全性開發變得更加容易。然而即使在安全設計上處處小心,對於極端環境 (例如醫療植入物) 仍然會有許多困難處須面對。

端到端的安全解決方案

大目標 (4):開發與技術、新威脅和新案例保持同步的安全性和隱私先進技術,例如:可信賴及安全的自治和智慧系統,來確保未來硬體平台以及新興的後量子 (Post-Quantum) 和分佈式加密演算法的安全維護。

採取行動

- 當今系統在智慧化和普遍性的增長速度相當驚人。在此同時,這些系統的規模和複雜性的增加,迫使硬體專業化和優化來因應性能挑戰。所有這些功能上的進步都必須與安全性和隱私權上的進步同步。 例子包括解決機器學習或傳統加密技術中的弱點、保護個人數據的隱私、以及解決供應鍊或硬體中的漏洞。

建議:在未來十年,每年投資 6 億美元在 ICT 安全的新發展軌跡上的相關技術研發

巨大轉變 (五) — 能源效率

不斷增長的計算能源需求與全球能源生產間正在創造新風險,新的計算範式帶來更多的機會及顯著的能源效率改善。

傳統計算在能源效率上已接近根本極限

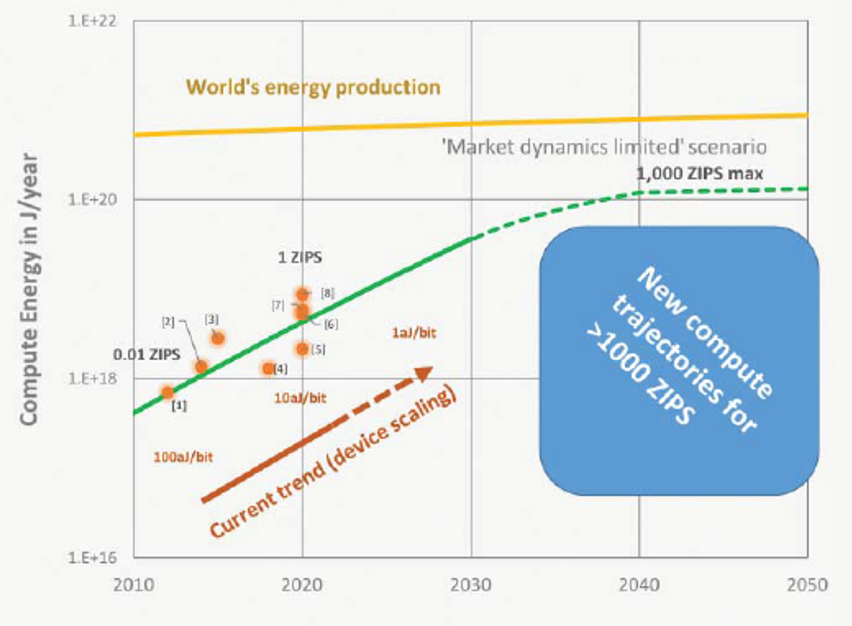

計算的位元數逐年增加。預計到 2050 年,我們要處理的位元數近 10^44 位元。通用計算的總能源消耗持續呈指數成長,大約每 3 年翻一倍,而世界能源產量僅呈線性成長,每年約 2%。

不斷增長的計算需求推動了全球計算能量的成長,儘管計算處理器單元 (如 CPU、GPU、FPGA) 中每一位元轉換的晶片層級能源消耗在過去 40 年中逐漸減少 (如摩爾定律所示),當前處理器中約為 10 aJ 或 10^-17 J。但是,對計算成長的需求超越摩爾定律所實現的進步。

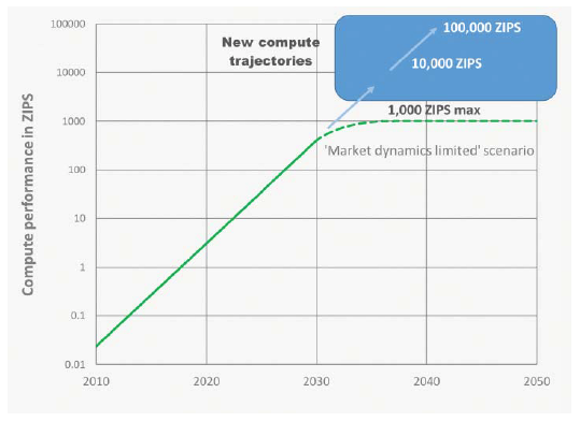

隨著元件縮放趨近基本物理極限,摩爾定律目前正在放慢速度。如果不考慮計算能量的指數型成長,市場動態將限制計算能力的成長,這將導致能量曲線趨於平坦 (參考下頁圖示)。因此,需要從根本上提高計算的能源效率,以避免發展受到限制。

全球能源產量不足以應付通用計算總能源消耗的持續性成長(下圖)

通用計算的總能源消耗持續呈指數成長,大約每 3 年翻一倍 (綠色實線)。而全球能源產量僅呈現每年約 2% 的線性成長 (黃線)。

摩爾定律目前正在放慢速度,市場動態將限制計算能力的成長,這將導致計算能量曲線趨於平坦。(綠色虛線)

藍色方框則表示一種全新的計算軌道被發展出來的場景。

全球計算能力將可能因能源限制而停止進一步成長(下圖)

綠色實線表示當前趨勢。

綠色虛線則表示因能源限制,全球計算能力將停止進一步成長的“市場動態受限”場景。

藍色方框則表示一種全新的計算軌道被發展出來的場景。

2010 至 2050 年,全球已安裝之計算資訊技術容量 (以 ZIPS 表示)

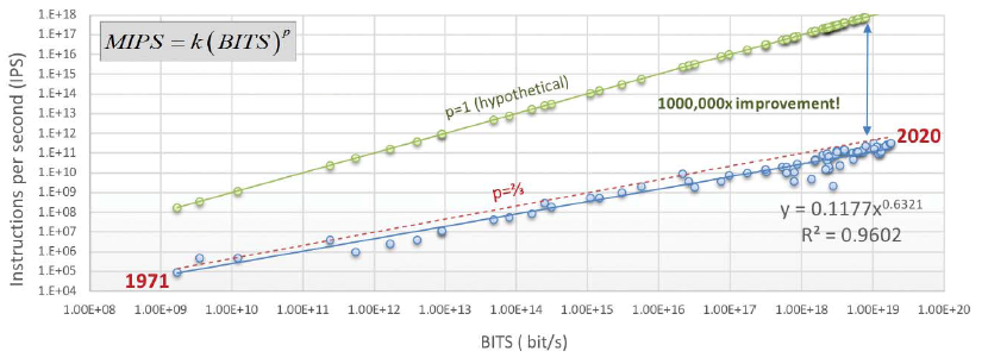

更改計算軌道將可以帶來百萬倍的計算效率和能源消耗改善(下圖)

- 當前的 CPU 計算軌道由一個功率公式描述,其指數設定為 p ~ 2/3。如果可以將公式中的指數增加約 30%, 即讓 p ~ 1,則計算效率和能源消耗將能有 1,000,000 倍的改善。(如下圖之綠色線所示)

大目標 (5):透過一個能論證其能源率效提高超過 1,000,000 倍以上的全新“計算軌道”來開發計算範式/架構。更改軌道不僅可以提供立即改善,還能提供數十年的緩衝期。這比試圖大幅增加世界能源供應的成本效益要高得多。

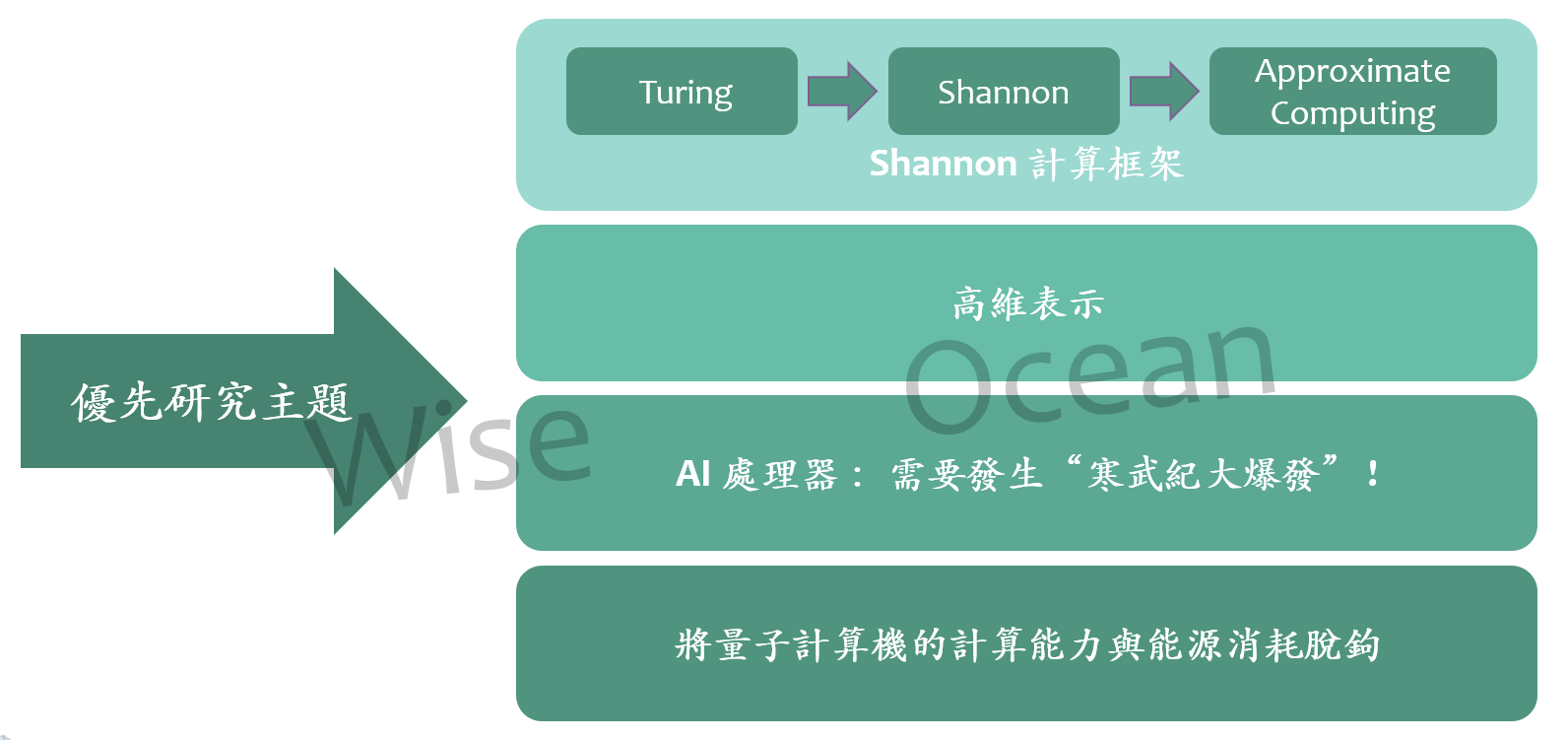

採取行動

- 我們很快將需要對計算進行革命性的改變。計算負載繼續呈指數型成增長,人工智慧 (AI) 應用程式和訓練需求的增長就是證明。新的計算方法如記憶體內 (In-Memory) 計算、特殊用途計算引擎、不同的 AI 平台、大腦啟發/神經形態計算、量子計算或其他解決方案等都將是必要的,並且需要以異構方式進行組合。

- 潛在的異構計算架構的範圍在最近的美國國家科學技術委員會 (NSTC) 關於計算的未來的報告中有所描述。這項研究將需要跨學科、跨功能的方法來實現能持續數十年,商業上可行和可製造的解決方案,以取代目前主流的數位方法。

- 報告旨在激發“從材料到架構和演算法”的協作研發,以建立能支援未來大量數據類型、工作負載和應用程式節能計算的革命性範式。

建議:在未來十年,每年投資 7.5 億美元來改變計算發展軌道

資料出處

decadal-plan-overview